统计显示,目前用于人工智能应用的数据中心的总能耗与塞浦路斯全国的能耗相当 。但最流行的人工智能处理器——Nvidia 的 H100 和 A100 的功耗又如何呢?

微软数据中心技术治理和战略首席电气工程师Paul Churnock认为,到 2024 年底,部署数以百万计的 Nvidia H100 GPU 时,Nvidia 的 H100 GPU 的能耗将超过亚利桑那州凤凰城所有家庭的能耗。然而,总耗电量将低于德克萨斯州休斯顿等大城市。

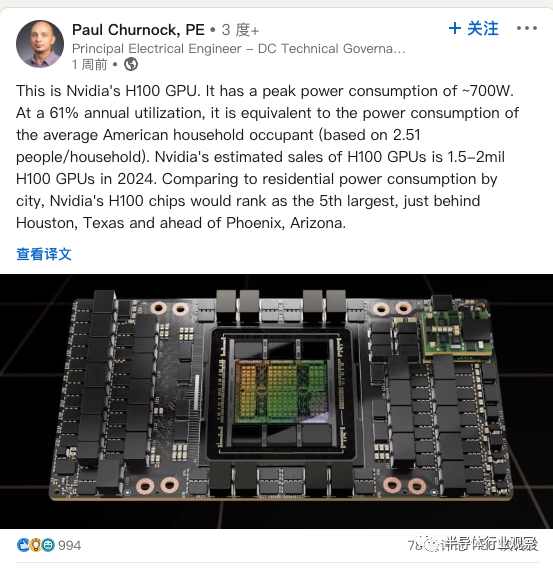

“这是 Nvidia 的 H100 GPU;它的峰值功耗为 700W,”Churnock 在 LinkedIn 帖子中写道。“以 61% 的年利用率计算,相当于美国家庭平均用电量(基于 2.51 人/家庭)。Nvidia 预计 2024 年 H100 GPU 的销量为 150万 – 200 万个 H100 GPU。与住宅用电相比按城市消费量计算,Nvidia 的 H100 芯片将排名第五,仅次于德克萨斯州的休斯顿,领先于亚利桑那州的菲尼克斯。”

事实上,如果年利用率为 61%,H100 GPU 每年将消耗约 3,740 千瓦时 (kWh) 的电力。假设 Nvidia 在 2023 年销售 150 万个 H100 GPU,在 2024 年销售 200 万个 H100 GPU,那么到 2024 年底将部署 350 万个此类处理器。总共,它们每年将消耗高达 13,091,820,000 千瓦时 (kWh) 的电力,或 13,091.82 GWh。

结合实际情况来看, 格鲁吉亚、立陶宛或危地马拉等国家的年耗电量约为 13,092 GWh。虽然这个功耗量看起来相当令人震惊,但值得注意的是,AI 和 HPC GPU 的效率正在提高。因此,虽然 Nvidia 基于 Blackwell 的 B100 的功耗可能会超过 H100,但它将提供更高的性能,因此每单位功耗可以完成更多的工作。