大模型Scaling Law(规模定律)将失效?长期以来,大模型的发展遵循依靠模型参数增加、数据集规模扩充以优化模型性能的规模定律。但随着可用于预训练的开源数据挖掘殆尽、模型训练所需的算力资源紧缺,大模型发展遵循的Scaling Law即将失效。

在近日举行的清华大学基础模型2025学术年会上,清华大学计算机科学与技术系副教授刘知远表示,“密度法则”将接替Scaling Law成为最新大模型迭代规律。根据这一法则,端侧智能将迎来广阔发展前景。

“密度法则”成为大模型发展新定律?

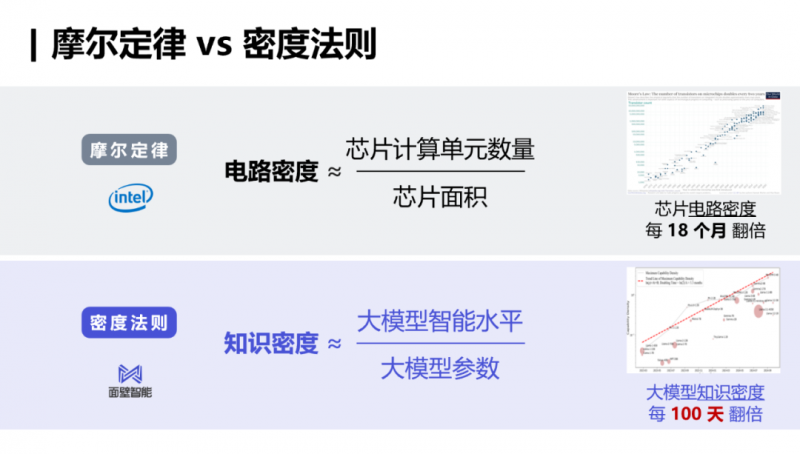

“芯片电路密度(即芯片计算单元数量与芯片面积的比值)每18个月翻1倍。”这是集成电路行业熟悉的摩尔定律。

刘知远提出的“密度法则”与这一规律类似,指大模型知识密度将每100天翻1倍。基于这一定律,刘知远认为,模型将朝着参数小型化、成本普惠的方向发展,并提出基于该定律的四条推论:

推论一:实现特定AI水平的模型参数呈指数下降,实现相同智能水平的模型参数量每3.3个月下降一半,同时模型推理速度提升一倍。例如,2024年2月发布的2.4B规模的MiniCPM-1,能力与2023年9月发布的7B规模Mistral相当,但参数量仅相当于后者的35%。

推论二:模型推理开销随时间呈指数级下降。例如,在过去20个月内,GPT-3.5级模型的API价格下降至原先的1/266.7,约2.5个月下降一半,而更低的价格将会带来更多的应用。

推论三:模型训练开销随时间迅速下降。高质量互联网数据规模约为15T,可训练的模型最大参数约为750B,但1年后,仅需58B参数模型便可实现相同能力。推论四:大模型能力密度呈加速增强趋势。ChatGPT发布之前,大模型能力密度约按每4.8个月增加1倍的速度增长;ChatGPT发布后,大模型密度倍增时间缩短至3.2个月。

模型小型化彰显端侧AI能力

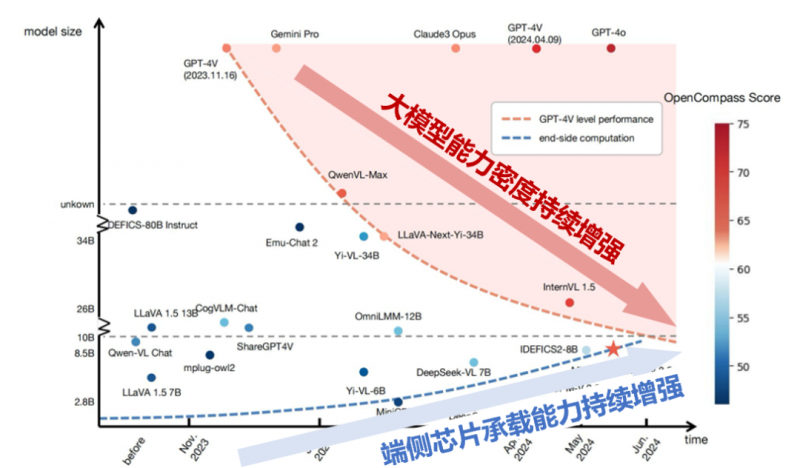

在“密度法则”下,模型将沿着这样的路径发展:同等智能水平模型的训练、推理开销等成本降低,模型规模缩小,能力密度持续增强。与此同时,在摩尔定律仍在发挥作用的情况下,端侧芯片的承载能力仍在增强。

这意味着,随着时间的推演,将出现能力水平非常高的大模型,同时其参数规模能够缩小到一定的程度,使其能够装载到消费级计算设备上。届时,端侧AI能力将得以彰显。但将运行在云端的PB级的知识规模浓缩到GB级的小模型参数中,是一项具备挑战性的工作。如何进行海量互联网数据的治理、如何利用数据背后的知识实现模型高效学习以实现大模型的科学化制备,将成为未来大模型构建的关键课题。

智能算法创新远未收敛

在过去5年中,一项项技术创新推动着大模型的发展:2018年出现的自监督预训练技术,使大模型具备了掌握人类知识的能力。但这一阶段,模型只是实现了学习,还不能实现模型应用;2021年,有监督的微调技术,使模型具备了理解人类意图的能力,可从用户的负责指令中挖掘出人类的真实意图,并调用自己掌握的知识,完成该指令。

2025年,模型借助强化学习技术,具备了深度思考的能力,可以在完成任务之前,像人一样深思熟虑,通过一步一步的思考给出准确的回答。面向未来,刘知远认为,智能算法创新和演进远远没有收敛,未来人工智能迈向AGI(通用人工智能)过程中还要不断拓展能力树,这也是人工智能迈向的核心任务之一。其需要拓展的能力包括自主学习、合作、创新创造等。如果停止算法创新,则将落后于其他发展AI能力的行业参与者。

就像人类个体具备一定智能水平之后,其彼此之间通过协同实现了群体智能涌现一样,刘知远认为,人工智能在结束个体的智能涌现之后,将通过多智能体群聚,迎来群体智能的第二次涌现。就像互联网把全球信息和人连接在一起,群体智能就有机会通过智能体互联网连接在一起,实现智能的二次涌现。制定智能体接入与沟通协议,有利于异质智能体沟通协作,共同完成任务。且不同专业能力的智能体有机结合,将完成个体所不能胜任的更复杂的任务。