Yole称,尽管2022年全球通胀大幅飙升,半导体市场历经周期波动、需求低迷的窘境,但微控制器(MCU)市场在2022年仍然蓬勃发展,总体年收入增长25%。

2023年来,许多供应商开始担心库存过剩,以及受到消费市场支出急剧下降和供应过剩导致平均销售价格和收入下降的严重影响,预计2023年MCU市场全年增长将持平,同时2024年将保持低个位数增长,但MCU市场的长期增长潜力尤其乐观

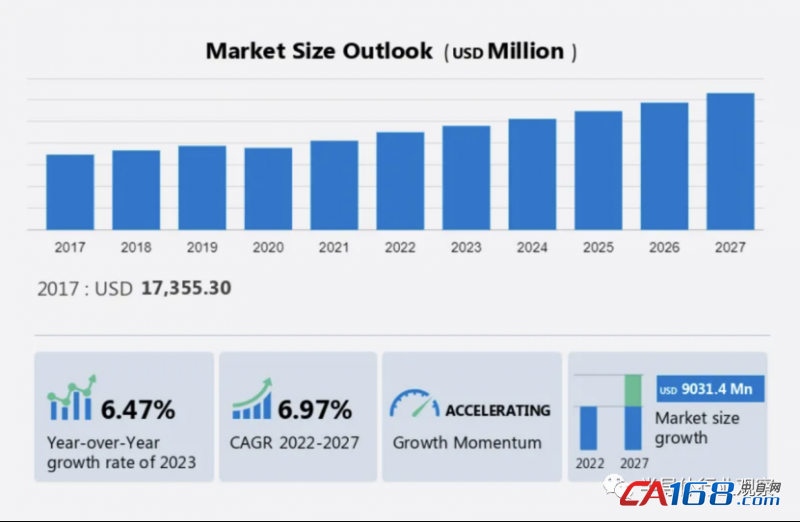

根据technavio报告预计,2022年-2027年间,MCU市场规模将以6.97%的复合年增长率增长,到2027年市场规模预计将增长90.314亿美元。

图源:technavio

市场的增长取决于多种因素,包括汽车中MCU的使用量不断增加、物联网和智能设备的需求不断增加以及消费电子行业的增长。

在这个过程中,互联设备的持续增长以及在物联网边缘开发更多智能设备的趋势。随着AI深入到边缘和终端装置,边缘计算的发展成为推动全球MCU市场增长的主要趋势之一。

这些趋势不仅推动了MCU的市场需求,也在催生MCU新的技术革新。

众所周知,此前的AI运算和机器学习等主要在云端完成,现在正在逐渐向边缘端发展。边缘计算是指在网络边缘运行的计算,更靠近数据生成源,而不是位于遥远的数据中心。这样做的好处在于,能减少云端上传的数据带宽,提升本地设备的响应速度,提高本地数据的安全性。

随着边缘计算在物联网领域不断部署,MCU在边缘计算中的使用将会增加。与此同时,在万物互联的时代,数据呈现爆发式的增长态势,CPU面临着巨大的计算压力。针对“如何释放CPU的计算压力”,市面上已经出现不同的解决方案。一些企业开始在MCU中添加加速器,通过专用算力来进行ML的运算,以期能释放CPU的通用算力。

简而言之,AI和ML的运算正在从云端向边缘端迁移,计算重心的前置可以提高本地的设备响应,减少云端上传的数据带宽,提高本地数据的安全性等,带来的好处不言而喻。而这种边缘AI,并不会止步于手机、电脑这些具备SoC级别算力的终端,而是会继续向着MCU为主控的物联网设备蔓延。

对此,MCU厂商相继进行创新,尝试将AI/ML技术集成到MCU中推向边缘,以跟上更智能的边缘设备的步伐,当前已有一些企业展开了探索布局。

头部MCU大厂,纷纷发力

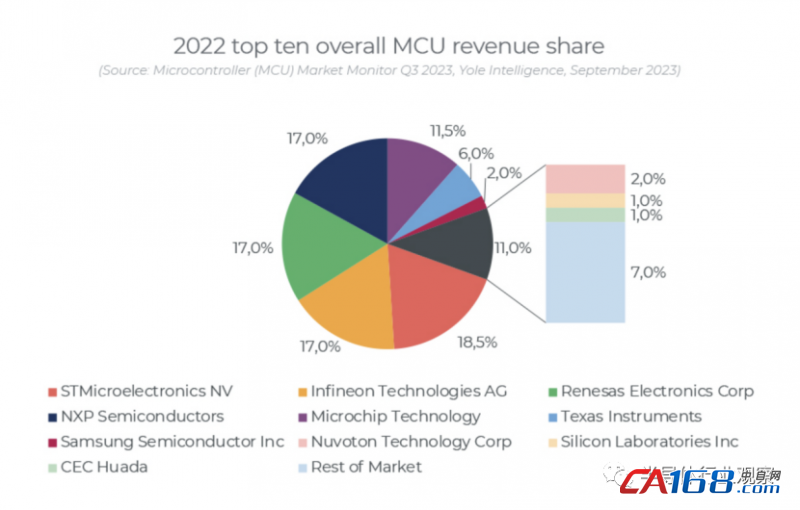

根据Yole统计数据,2022年全球MCU厂商营收排名中,意法半导体(STM)、英飞凌(infineon)、瑞萨电子(Renesas)、恩智浦半导体(NXP)、微芯科技(Microchip)位列前五,Top10企业市场份额合计占比高达93%。

本文以头部MCU厂商为例,针对上述边缘设备市场的发展,来看一看MCU行业正在如何进行创新与演变。

恩智浦:率先将NPU集成进通用MCU

恩智浦曾表示,“以前提到好MCU的标准就是:按下按钮就有很快的反应,但现在远不止这样,我们希望处理器本身有预知性,这就需要引入AI的要素。所以相信越来越多的落地项目会要求边缘计算平台拥有越来越多的AI功能支持。”

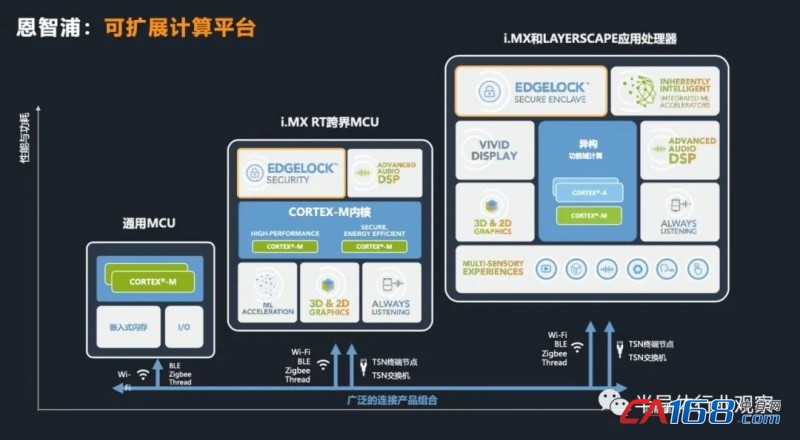

熟悉恩智浦的人应该知道,NXP有三大类边缘计算平台,分别是通用MCU平台(LPC、Kinetis),跨界MCU i.MX RT系列,以及i.MX和Layerscape系列应用处理器,这三大类产品构筑了NXP广阔而丰富的可拓展的边缘计算平台。

近年来,恩智浦新推出的跨界MCU填补了MPU和MCU之间的市场空隙,获得了较好的市场反响。

在通用MCU市场,一个新纪元即将开启。据IHS预测,2030年将会有750亿个联网设备,这带来了新的MCU应用需求。低功耗、无线连接、安全、高性能和AI能力的追求,成为了新的通用MCU的必备能力。而且同一MCU平台需要具有灵活的可迁移性,方便开发者进行设计的迁移。

基于智能边缘的种种趋势,NXP推出了通用MCU平台——MCX微控制器产品组合。这一平台融合了LPC、Kinetis传统优势,将开启下一段智能边缘的征程。

传统上,要将一些成熟的算法部署到MCU的CPU核上,需要耗费大量精力,且难度较大。目前MCU厂商都有推出相应的AI开发工具包,或者是例程,供开发者使用。

但另一个问题在于,MCU的CPU核并不适合做AI和ML的运算,这将会极大地占用其计算资源。高度依赖CPU核和FPU等硬件资源,也会带来功耗的上升,从系统角度来看并不是合适的做法。

因此,在通用MCU中添加一个硬件NPU,来为一些边缘侧通用的AI运算进行专门的加速,成为了解决问题的优选。CPU核可以专注于自己擅长的计算任务,将AI ML的运算交给NPU。

上述MCX N系列就是如此,让适合的核去做适合的任务,从而帮助开发者实现未来智能边缘更好的设计。

据介绍,NPU作为CPU的AI运算协处理器,其内部最主要是拥有专门的计算通道。该NPU为NXP的自研硬件IP,在MCU领域中,集成神经处理单元应该说是迎合了这个时代。

未来,该NPU还可以扩展到更高的性能或更小的单元。NXP的整个MCU、MPU家族里,都会采用统一的NPU架构,提供更高性能的NPU的加速器。通过一致的NPU架构,同样的算法也更容易从MPU迁移到MCU平台上。

相比一些AI SoC,NXP N系列产品的通用性更好,能够覆盖到更多基础应用的AI特性升级;而对于一些AI更加前置、在传感器中添加加速器的产品而言,其加速器往往功能比较单一,仅适用于其传感器的数据筛选,并不具备更灵活的通用性,不能支持更多算法模型。

近日,恩智浦最新宣布与Aptos-Eta Compute建立合作伙伴关系,将恩智浦先进的以人工智能为核心的芯片和软件工具集成到Aptos公司领先的MLOps平台上。

在此过程中,Aptos可以针对该芯片优化和调整人工智能模型,从而实现前所未有的模型效率和性能,简化低功耗边缘处理器的模型开发、部署和管理。

这次合作标志着在缩小AI和嵌入式系统之间的差距方面迈出了重要一步。Aptos无需复杂地了解芯片的具体功能和限制条件,从而为机器学习开发人员和嵌入式系统工程师提供了强大的支持。人工智能开发人员现在可以轻松创建和部署优化的机器学习模型,充分利用恩智浦芯片的强大功能,无需深入了解嵌入式技术,即可管理片上内存和低功耗等紧张资源。嵌入式系统工程师可以使用无代码工具链轻松获得最佳的Al模型。这种“简化+优化”是使Edge Al革命成为现实的核心,使其比以往任何时候都更容易获得和高效

Eta Compute共同创办人暨行销副总裁Paul Washkewicz表示,在Edge Al快速发展的世界中,协作是成功的关键。Eta Compute和恩智浦半导体的合作标志着业界致力于打破障碍,为更多领域提供有效的解决方案,从而推动边缘人工智能的发展。

据悉,MCX的应用场景是针对MCU现有的应用场景进行的拓展,在传统的控制应用基础上增加了在医疗设备、无人机,或者工业控制中加上智能识别、故障检测、语音控制等应用。基于NPU的出现,也会衍生出很多新应用,例如在日常生活中识别物体的秤;医学检测中,可以应用于检测含疟疾的红细胞;交通出行中,可以帮助智能车识别障碍,自动地做出判断和处理等等。

整体来看,高性能、无线、安全和AI特性,具备所有这些特性的通用MCU平台是大势所趋。业界很多厂商其实也已经有非常完备的平台,但在通用MCU中添加硬件NPU,MCX尚属首例,可谓是NXP又捕捉到了一个广阔前景的市场空白和清晰的应用前景。

英飞凌:板载ML硬件加速

近日,英飞凌宣布推出PSoC Edge系列微控制器,为边缘操作机器学习 (ML) 的设备提供高性能和安全性。

PSoC Edge系列MCU提供内置ML支持、自主模拟以及更多功能,使其成为下一代智能边缘设备的候选者。

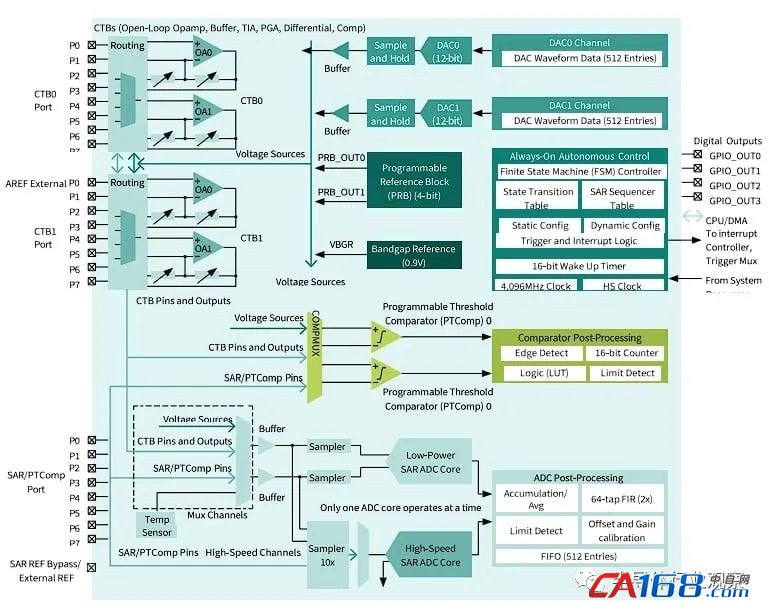

PSoC Edge 系列MCU框架

值得关注的是,除了支持Cortex-M55 DSP和Ethos-U55 NPU之外,PSoC Edge系列MCU的一个关键规格是板载ML硬件加速,集成了英飞凌专有的神经网络硬件加速器NNLite。

这种硬件加速使该系列MCU能够用于需要响应计算和控制的各种应用,包括智能家居、可穿戴设备和人机交互设计。然而,除了这些特定领域之外,设计人员还可以在任何需要片上ML加速的应用中使用PSoC Edge MCU。

以物联网设备为例,机器学习功能可用于自适应地与环境交互,而机器人用例可以利用机器学习功能来提高自主设备的效率和性能。同时,随着向边缘设备分配更多计算能力的趋势不断发展,PSoC Edge系列MCU为应用设备提供了更多的功能和安全性。 随着越来越多的开发人员使用该芯片,他们可以评估片上ML加速和自主模拟信号链带来的性能提升。

另外,开发工具也是用户在开发MCU过程中必不可少的一环。为了更好的支持AI功能的开发,英飞凌还推出了ModusToolbox机器学习工具,能够快速评估ML模型并将其部署到英飞凌MCU上。ModusToolbox ML旨在与BSP、连接堆栈、中间件和有直观的配置器的ModusToolbox软件生态系统无缝协作,以便开发人员可以专注于他们的应用程序差异化并加快进入市场。

此外,为支持汽车人工智能和车辆虚拟化的趋势,英飞凌还与新思科技合作推出了针对AI加速的Aurix TC4x平台,英飞凌的AURIX TC4x MCU集成了一个高性能AI加速器,称为并行处理单元 (PPU),由Synopsys DesignWare ARC EV处理器IP提供支持。

在AURIX TC4x架构中集成基于ARC EV处理器的PPU,通过提供经济实惠的AI实现了广泛的电动汽车用例。PPU具有实时处理性能,可加速循环神经网络、卷积神经网络和多层感知器等AI算法。除了提供处理能力之外,ARC EV7x处理器IP还提供功能安全特性,与AURIX架构相结合,支持开发更安全的汽车系统。

2023年5月,英飞凌宣布已收购总部位于瑞典斯德哥尔摩的初创公司Imagimob AB,以提升其微控制器和传感器上的TinyML边缘AI功能。Imagimob是快速增长的微型机器学习和自动机器学习(TinyML和AutoML)市场的领先者。

ST:AI软硬结合,赋能MCU

近几年,智能家电的快速发展,对MCU的性能、互联提出了越来越高的要求,基于MCU平台运行人工智能和机器学习,发展性能更高、功耗更低的边缘计算,正在成为行业热点。面对这样的趋势,意法半导体很早就开始布局智能的MCU。

ST已经创建了一个平台,通过STM32Cube-AI将ML用于32位MCU

2021年6月,意法半导体宣布收购边缘AI软件专业开发公司Cartesiam,让基于Arm的MCU具有机器学习和推理能力。去年,ST推出了带有神经网络硬件处理单元的通用微控制器——STM32N6,这是意法半导体的首款带有神经处理单元硬件加速器的MCU,将推动目标应用计算能力的提升和功耗、成本的进一步下降。与其STM32MP1微处理器相比,这款MCU的推断速度提高了25倍。

据了解,STM32N6包括一个专有的NPU和一个ARM Cortex内核,这提供了与配备AI加速器的四核处理器相同的AI性能,但成本仅为十分之一,功耗仅为十二分之一。

今年5月,ST推出了其最新的64位微控制器STM32MP2。凭借多个ARM Cortex内核、一个神经处理单元、一个图形加速器和多个高性能I/O选项,ST将新处理器定位于工业4.0应用中的机器学习。

此外,意法半导体的软件工具STM32CubeMX中也集成了AI模块,可以方便客户将训练好的AI模型转换为MCU上运行的软件,使MCU可以方便实现AI功能。

ST还拥有STM32Cube.AI和NanoEdge AI Studio软件工具,并且与NVIDIA合作,整合NIVIDIA TAO和STM32Cube.AI工具,让开发者在STM32微控制器上无缝地训练和实现神经网络模型。

相对来说,两个优势互补的软件工具STM32Cube.AI和NanoEdge AI Studio,产品种类丰富的STM32微控制器和微处理器,以及大量的传感器产品组合,让ST的人工智能解决方案成为市场上比较丰富的人工智能产品组合。

瑞萨电子:业界首款M85处理器MCU

近年来,很多厂商开始尝试在MCU中融入AI功能,瑞萨电子也是关注MCU+AI的厂商之一。

随着对效率、延迟以及成本的考虑,市场开始尝试采用越来越多的边缘计算作为嵌入式系统AI/ML的首选方案。

作为全球主要的MCU和MPU供应商,瑞萨电子的AI解决方案通过使用在终端具有智能数据处理能力的嵌入式AI技术,来增强以信息和操作技术为基础的系统和产品。

早在2021年,瑞萨就推出面向AI的领先MPU产品。入门级RZ/V2L系列具备同类的电源效率和高精度AI加速器DRP-AI,可进行AI推理和图像处理,以实施更具成本效益的视觉AI应用。此外,通用64位RZ/G2L产品群采用最新Arm Cortex-A55核心,用于改进AI处理。

去年,瑞萨还推出了内置视觉AI加速器的RZ/V2MA系列产品,进一步实现了精确图像识别和多摄像头图像支持功能。

据了解,RZ/V2系列是一种内置瑞萨电子独家硬件加速器 “DRP,动态可配置处理器-AI”的AI专用微处理器。DRP-AI专为嵌入式机器视觉类AI/ML应用优化设计,可提供实时AI推理和图像处理功能,同时兼具了高AI推理性能和低功耗特性,家族化产品支持0.4~80TOPS不等的可扩展AI算力,为资源有限的嵌入式端侧AI应用提供差异化有竞争力的解决方案。

瑞萨表示,MCU与MPU的计算效率和实时处理AI/ML模型的能力不断提高,随着各类应用对AI/ML技术的普遍采用,MCU和MPU将继续增加AI加速结构和NPU。

近日,瑞萨电子再次推出强大的RA8系列MCU,新型RA8系列MCU部署了Arm Helium技术,即Arm的M型向量扩展单元。相比基于Arm Cortex-M7处理器的MCU,该技术可将实现数字信号处理器(DSP)和机器学习(ML)的性能提高4倍。

AI的出现增加了对边缘和终端智能的需求,以服务于包括工业自动化、智能家居和医疗在内不同市场的新应用。瑞萨的新型RA8系列为MCU的性能和功能设定了新的标准,并将简化AI在大量新应用中的实施,对于希望在嵌入式和物联网领域把握不断增长的AI机遇且兼顾安全性的创新者来说,其将改变游戏规则。

在AI软件方面,瑞萨电子也在持续强化布局。瑞萨去年中旬完成对Reality AI的收购,可为汽车、工业和消费类产品中的高级非视觉传感提供嵌入式AI和微型机器学习(TinyML)解决方案。Reality AI的旗舰Reality AI Tools是一种为支持整个产品开发生命周期而构建的软件环境,可提供来自非视觉传感器数据的分析。

目前,Reality AI的全套工具已被用于支持瑞萨所有的MCU和MPU产品线,用户可利用该工具套装去优化自己的AI和ML模型,对外提供支持AI运算的MCU。

ADI:硬件CNN集成,边缘AI MCU的技术趋势

在很多垂直的边缘端要实现AI赋能,调用云端的AI能力的成本较高,而且整个链条的响应时间也较长,对于连接质量的依赖程度也较高,因此并不能做到较为实时的计算和处理,这与端侧的低功耗、低延时的系统设计目标并不相符。

边缘AI落地,需要满足端侧的功耗要求。

因此,内置硬件CNN进行专门的AI运算,成为了ADI在AI MCU上最佳选择。在端侧计算单元中部署一个资源够用的卷积神经网络(CNN)加速器,就可以承担起端侧的AI任务,而且也释放了更擅长做计算任务的CPU等资源,从而在增加AI运算的同时,还保证了达到端侧高能效目标。

据了解,在百亿IoT设备中,大部分的计算单元是MCU。而在MCU中集成CNN加速器,已经成为了MCU的一个发展方向。目前诸多MCU厂商都已经推出了AI集成的MCU产品,ADI也是如此。

据预测,2025年75%的数据产生在边缘侧进行处理,端侧AI MCU市场潜力巨大。

以ADI推出了边缘AI解决方案MAX7800X系列MCU为例,MAX7800X系列由两个微控制器内核(ARM Cortex M4F和RISC-V)加上一个卷积神经网络(CNN)加速器构成。这一架构针对边缘AI应用进行了高度优化,数据的加载和启动由微控制器内核负责,而AI推理由卷积神经网络加速器专门负责。

据了解,ADI的边缘AI解决方案具备速度快、无需外部存储、时钟控制灵活和超低功耗等四大特色,因此对于需要使用电池供电、需要及时决策的物联网设备来说特别合适。

针对边缘AI的计算平台,相较于选择FPGA、GPU、DSP或其它专用ASIC,但ADI的MAX7800X凭借着针对性的架构设计,提供了更高的能效和性能表现。

对比传统的MCU+DSP的方案,ADI的MAX7800X的CNN加速器可以将功耗降低99%以上,而且算法在CNN上执行的效率也比DSP上更高。对于单纯采用微控制器的方案,MAX7800X的CNN加速器具备更高的数据吞吐量,可以将速度提高100倍以上;而且释放了CPU的工作负载,使其专注于更擅长的计算任务。而对于FPGA等方案,虽然可以处理更复杂的细节,但其成本、功耗和面积都并不适合更边缘侧的部署,MAX7800X也具备更大的优势。

随着AI在边缘的落地,硬件CNN在端侧MCU的集成已经成为一种技术趋势。这种AI MCU的发展将会迎来巨大的市场机遇。

MCU初创公司:瞄准AI加速器

此外,一些AI初创公司,如Brainchip、Hailo、Alif已经瞄准了AI加速器,可以用于MCU应用。以Alif为例,

Alif Semiconductor推出的Ensemble系列融合微控制器,“融合”了不同的计算技术——实时MCU内核、机器学习加速器和一些应用MPU内核,可以有效处理电池供电设备上繁重的机器学习工作负载。

据悉,其性能比使用各种AI模型执行类似工作负载的传统32位MCU高出两个数量级。

Alif 的新系列 Ensemble 微控制器和微处理器

随着系统设计人员寻求减少AI/ML处理对云的依赖,像Ensemble系列这样的可扩展边缘AI解决方案可能会在未来几年取得进步。

Arm:MCU+AI需求强烈

作为众多MCU芯片厂商的内在赋能者,Arm近年来连续发布了带有算力的内核MicroNPU Ethos U55、U65等系列,标志着MCU市场对AI加速器开始提出更强需求。

如今在MCU中加入AI加速器逐渐变得流行起来,使用Tiny ML/Embedded ML把算法部署在MCU上,还可以根据不同的应用场景轻巧灵活地部署在不同架构和资源的通用MCU上。

Arm在短时间内连续发布两代针对MCU的microNPU,一方面说明MCU市场对于AI和AI加速器确实有很强的需求;另一方面也表明MCU和MPU甚至CPU之间的性能差距正在缩小,这将为未来智能MCU生态带来新的变化。

AI和MCU的融合或将解锁一个庞大的市场,或成为未来万物互联的基石。

同时也看到,除了在MCU中集成硬件加速器,在MCU中解决边缘AI的更流行的趋势在于算法的发展,ML算法可以使用更小的工具来开发,如TinyML和TensorFlow Lite,使其能够在MCU等受限硬件中开发AI应用。

上述也提到了瑞萨电子、英飞凌、ST等均在发力AI软件方案,去优化AI和ML模型。对此,MCU大厂Microchip(微芯科技)也在布局,为了满足边缘端机器学习开发和设计需求,Microchip也推出了完整的集成工作流程,通过其新的MPLAB机器学习开发套件来简化ML模型开发。该软件工具包可在Microchip的MCU和MPU产品组合中使用,以快速高效地添加ML推理。

写在最后

AIoT时代,AI深入到边缘和终端装置,已经是一个长期必然的大方向。

相比于传统方式,边缘AI凭借独特优势能够给各行业提供更令人满意的解决方案,越来越多的人在尝试使用边缘AI来解决行业的痛点问题。

在MCU中集成硬件加速器或融入AI算法,可以将MCU低功耗、低成本、实时性、稳定性、开发周期短、广阔的市场覆盖率等特性,与人工智能强大的处理能力相结合,从而更有利于终端智能化市场的发展。

回顾行业历程,大概自2017年开始,MCU厂商尝试在MCU中添加AI功能。例如,ST的Project Orlando项目作为实验性质的MCU超低功耗AI加速器单元,瑞萨在2018年发布了针对MCU的可编程可重构协处理器DRP。

至今,经过多年发展,在MCU中加入AI加速器正在变得越来越主流。

将AI能力集成到MCU上,使得AI算法可以实时地在设备本地进行处理和响应,而无需依赖于云端或其他远程服务器。这提高了系统的实时性和即时响应能力,使得设备能够更快速地做出决策和反应,且可以在低功耗的情况下实现高效的AI计算。

当MCU市场开始拥抱AI,一个全新的AIoT局面即将开启。在下一波百亿物联设备的背后,MCU行业将迎来新的变革与重构。