在AI大模型爆火的当下,GPU被疯抢,连带HBM内存芯片也在一片寒冬的存储市场脱颖而出,成为三大原厂积极扩产的目标,并持续在该领域发力。

HBM是什么?

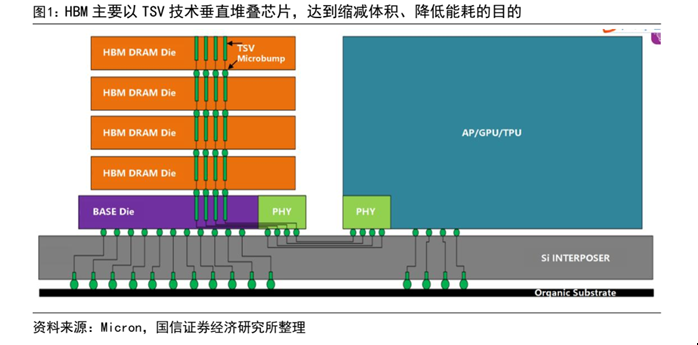

HBM(高带宽存储器, High Bandwidth Memory) 是一款新型的 CPU/GPU 内存芯片,是由 AMD 和 SK Hynix 发起的基于 3D 堆栈工艺的高性能 DRAM,适用于高存储器带宽需求的应用场合。HBM 以位元计算,通过增加带宽,扩展内存容量,让更大的模型、更多的参数留在离核心计算更近的地方,从而减少内存和存储解决方案带来的延迟,目的实现大容量,高位宽的 DDR 组合阵列,目前 HBM 占整个DRAM 市场比重约 1.5%,为新型高性能存储产品。

由于AI 大模型处理数据的吞吐量呈指数级增长,需要应用并行处理数据的 GPU 作为核心处理器,GPU搭载的内存芯片带宽关联 GPU 数据处理能力,高带宽的内存芯片可以为 GPU 提供更快的并行数据处理速度,对GPU的性能起到了决定性作用,HBM也顺势迎来发展机遇。

一系列配套性能自然决定了HBM的需求正不断飙升,三大存储原厂也看到了机遇,陆续决定扩产。

三大原厂积极扩产

据TrendForce集邦咨询研究显示,2022年三大原厂HBM市占率分别为SK海力士50%、三星约40%、美光约10%。此外,高阶深度学习AI GPU的规格也刺激HBM产品更迭,2023下半年伴随英伟达 H100与AMD MI300的搭载,三大原厂也已规划相对应规格HBM3的量产。

SK海力士方面,正在扩建HBM产线,计划将HBM产能翻倍,扩产焦点在于HBM3。据韩媒消息,SK海力士正在准备投资后段工艺设备,扩建封装HBM3的利川工厂,预计到今年年末,后段工艺设备规模将增加近一倍。值得一提的是,SK海力士在去年6月已率先量产了DRAM HBM3,且已供货英伟达的H100。另据Business Korea报道显示,英伟达已要求SK 海力士提供HBM3E样品,后者正在准备出货样品。

HBM3E是DRAM HBM3的下一代产品,目前SK海力士正在开发,目标明年上半年量产。

三星方面,据韩国ET News消息,三星电子将投资1万亿韩元(约合7.66亿美元)扩大HBM产能,目标是到2024年底将HBM产能翻一番,并且已经下了主要设备的订单。

美光方面,3月份的时候就宣布旗下第二代高带宽存储器(HBM2)即将开始出货。HBM2主要用于高性能显卡、服务器处理器以及各种高端处理器中。

价格是传统DRAM的2~3倍

价格方面,目前HBM的价格比较昂贵,原本就是传统DRAM的2~3倍。而在2023年开年后,随着三星、SK海力士的HBM订单快速增加,之前另有消息称HBM3较DRAM价格上涨5倍。需求方面,由于谷歌、苹果、微软等科技巨头都在筹划扩大AI服务,HBM需求自然水涨船高。

业内预计,明年三星与SK海力士都将进一步扩大投资规模。,“但若想满足未来需求,三星、SK海力士都必须将产能提高10倍以上。

TrendForce表示,从高阶GPU搭载的HBM来看,英伟达高阶GPU H100、A100主要采用HBM2e、HBM3。随着英伟达的A100/H100、AMD的MI200/MI300、谷歌自研的TPU等需求逐步提升,预估2023年HBM需求量将同比增长58%,2024年有望再增长约30%。

国盛证券指出,HBM最适用于AI训练、推理的存储芯片。受AI服务器增长拉动,HBM需求有望在2027年增长至超过6000万片。广发证券也补充,HBM方案目前已演进为高性能计算领域扩展高带宽的主流方案,并逐渐成为主流AI训练芯片的标配。

Omdia则预计,2025年HBM市场规模可达25亿美元。