凭借GPU强大的计算能力,超级计算机在数据处理、物理模拟、天气预测、现代制药、基因测序、先进制造、人工智能、密码分析等方面都有着广泛的应用。在2020年的新冠肺炎疫情中,更是为医疗卫生科研人员提供了巨大的帮助,为抗疫斗争赢得了宝贵的时间。从GPU在新冠肺炎疫情中的实际应用情况出发,回顾了GPU诞生至今40余年的主要发展历程,分析其发展趋势,提出了未来可能的若干发展方向,并结合本单位GPU研制实践,阐述了国产GPU研制的特点及现状,列举了多项关键技术,对国产GPU的未来发展提出了展望。

引言

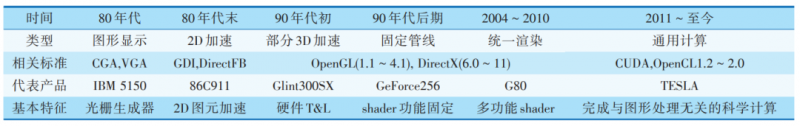

1.GPU发展历程

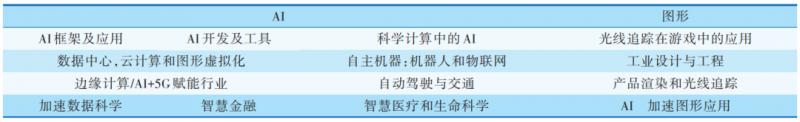

2.GPU未来趋势

2.1 高性能计算

2.2人工智能计算

2.3 光线追踪-更加逼真的图形展现

2.4 高清显示

2.5 高效能

3.国产GPU的研制实践

4.结论与展望